Những rủi ro bảo mật phổ biến khi triển khai mô hình AI mã nguồn mở

Mô hình **AI mã nguồn mở** (open-source AI models) ngày càng được áp dụng rộng rãi trong nhiều lĩnh vực nhờ vào tính linh hoạt và khả năng tùy chỉnh. Tuy nhiên, việc triển khai những mô hình này không phải là một hành trình không có rủi ro. Chính sự tự do trong việc truy cập và chỉnh sửa mã nguồn cũng đồng nghĩa với những lỗ hổng bảo mật dễ dàng bị khai thác. Trong bài viết này, chúng ta sẽ cùng tìm hiểu các rủi ro bảo mật phổ biến khi triển khai mô hình AI mã nguồn mở và cách phòng tránh chúng.

### Các loại rủi ro bảo mật trong mô hình AI mã nguồn mở

#### Mã độc và cửa hậu trong mô hình AI

Một trong những rủi ro lớn nhất khi sử dụng **mô hình AI mã nguồn mở** chính là khả năng chứa mã độc hoặc cửa hậu (backdoors). Những lỗ hổng bảo mật này có thể xuất hiện ngay trong quá trình huấn luyện mô hình hoặc trong các gói mã nguồn mà người dùng tải về từ các kho mã nguồn công khai như **Hugging Face** hay **GitHub**.

Mã độc này có thể được chèn vào trong dữ liệu huấn luyện hoặc các siêu dữ liệu của mô hình mà người dùng không thể dễ dàng nhận ra. Nếu không được phát hiện kịp thời, những phần mềm độc hại này có thể giúp kẻ tấn công chiếm quyền điều khiển hệ thống của bạn, truy cập dữ liệu nhạy cảm hoặc thậm chí thực hiện các cuộc tấn công từ xa.

Một ví dụ điển hình là việc tải về mô hình AI từ **Hugging Face**—một nền tảng phổ biến cho việc chia sẻ mô hình AI mã nguồn mở. Mặc dù nền tảng này có nhiều mô hình chất lượng, nhưng nếu người dùng không kiểm tra kỹ lưỡng trước khi sử dụng, các mô hình có thể chứa mã độc được tiêm vào trong quá trình huấn luyện, gây ra các nguy cơ bảo mật nghiêm trọng.

#### Tấn công chuỗi cung ứng trong AI

Một trong những điểm yếu của mô hình **AI mã nguồn mở** chính là **tấn công chuỗi cung ứng**. Khi các mô hình AI được phân phối qua các kho mã nguồn mở, kẻ tấn công có thể lợi dụng sự thiếu hụt trong việc kiểm soát nguồn gốc và xác thực tính an toàn của từng thành phần trong chuỗi cung ứng.

Các cuộc tấn công này có thể xảy ra khi kẻ tấn công thay đổi các mô hình trong quá trình phân phối hoặc tiêm mã độc vào các thư viện phụ thuộc mà mô hình AI sử dụng. Các cuộc tấn công này sẽ rất khó phát hiện vì chúng thường ẩn mình trong các phần mềm phụ thuộc mà người phát triển không hề nghi ngờ.

Việc thiếu chuẩn xác thực mô hình và việc không có các quy trình kiểm tra bảo mật đầy đủ trong chuỗi cung ứng làm tăng nguy cơ bị tấn công. Để giảm thiểu nguy cơ này, các tổ chức nên áp dụng các công cụ bảo mật để kiểm tra từng phần mềm phụ thuộc và xác thực các mô hình trước khi sử dụng.

#### Lỗ hổng trong mã và dữ liệu

Các **lỗ hổng bảo mật** trong mã hoặc dữ liệu cũng là một vấn đề đáng lo ngại khi triển khai mô hình AI mã nguồn mở. Các mô hình AI có thể chứa các lỗi trong mã nguồn hoặc xử lý dữ liệu không an toàn, dẫn đến khả năng bị tấn công từ xa, rò rỉ dữ liệu, hoặc nâng cao đặc quyền trái phép.

Một nghiên cứu được thực hiện bởi **Springer Nature** cho thấy hơn 30 lỗ hổng bảo mật nghiêm trọng đã được phát hiện trong các mô hình AI mã nguồn mở. Những lỗ hổng này bao gồm việc thiếu kiểm soát quyền truy cập và việc xử lý dữ liệu không bảo mật, điều này khiến dữ liệu của bạn dễ dàng bị lộ ra ngoài hoặc bị truy cập trái phép.

Các mô hình AI không được kiểm tra kỹ lưỡng hoặc sử dụng các thư viện không bảo mật có thể làm gia tăng các nguy cơ liên quan đến việc rò rỉ dữ liệu nhạy cảm hoặc làm lộ thông tin cá nhân.

### Các giải pháp giảm thiểu rủi ro bảo mật khi sử dụng AI mã nguồn mở

#### Quy trình kiểm tra và xác thực mã nguồn mở

Một trong những cách hiệu quả nhất để giảm thiểu rủi ro bảo mật khi sử dụng **mô hình AI mã nguồn mở** là thực hiện quy trình kiểm tra và xác thực mã nguồn chặt chẽ. Điều này bao gồm việc kiểm tra mã nguồn của các mô hình AI trước khi triển khai để đảm bảo rằng chúng không chứa mã độc hoặc phần mềm nguy hiểm.

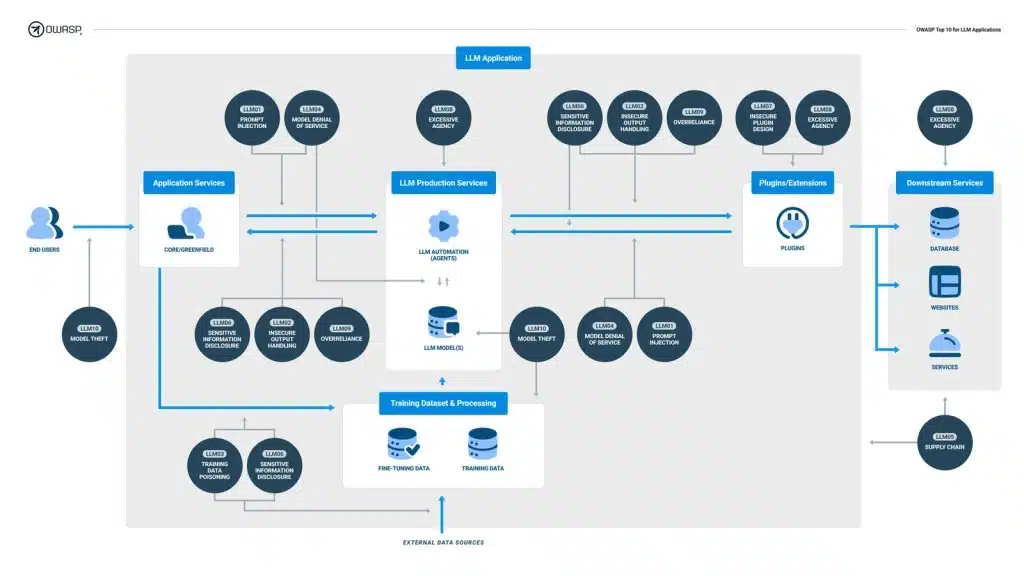

Các công cụ như **OWASP AI Security** cung cấp hướng dẫn và các công cụ kiểm tra bảo mật dành cho các mô hình AI mã nguồn mở. Trước khi triển khai mô hình, các nhà phát triển và tổ chức nên sử dụng các công cụ này để quét mã nguồn và xác định các điểm yếu bảo mật.

Bằng cách kiểm tra kỹ lưỡng các mô hình AI và xác thực các thư viện phụ thuộc, tổ chức có thể giảm thiểu đáng kể nguy cơ từ việc sử dụng mô hình AI mã nguồn mở.

#### Quản lý quyền truy cập và khóa API

**Quản lý quyền truy cập và khóa API** là một yếu tố rất quan trọng để bảo vệ mô hình AI mã nguồn mở khỏi các cuộc tấn công. Việc lạm dụng khóa API hoặc cấp quyền truy cập không đúng có thể dẫn đến việc kẻ tấn công chiếm quyền điều khiển hệ thống hoặc rò rỉ dữ liệu.

Các tổ chức cần thực hiện các biện pháp bảo mật như mã hóa khóa API, chỉ cấp quyền truy cập cho những người có thẩm quyền và kiểm tra lịch sử truy cập để phát hiện các hành vi bất thường. Việc quản lý tốt quyền truy cập giúp giảm thiểu nguy cơ bị tấn công hoặc lộ thông tin quan trọng.

### Các công cụ hỗ trợ bảo mật cho mô hình AI mã nguồn mở

Hiện nay, có nhiều công cụ hỗ trợ bảo mật cho mô hình **AI mã nguồn mở**. Các công cụ này giúp các tổ chức xác định các lỗ hổng bảo mật và giảm thiểu nguy cơ khi triển khai mô hình AI. Một số công cụ phổ biến bao gồm:

– **OWASP AI Security**: Một bộ công cụ bảo mật đặc biệt dành cho các mô hình AI, giúp xác định các lỗ hổng và nguy cơ bảo mật trong mô hình AI mã nguồn mở.

– **Hugging Face Model Hub**: Nền tảng chia sẻ mô hình AI mã nguồn mở có công cụ kiểm tra bảo mật giúp người dùng xác minh tính an toàn của các mô hình trước khi tải về và sử dụng.

Việc sử dụng các công cụ này sẽ giúp đảm bảo rằng mô hình AI không chứa các mã độc hoặc lỗ hổng bảo mật nghiêm trọng trước khi triển khai.

—

*Để biết thêm các giải pháp bảo mật cho AI mã nguồn mở, hãy tham khảo các dịch vụ từ [TRANBAO.DIGITAL](https://tranbao.digital).*

Các giải pháp giảm thiểu rủi ro bảo mật khi sử dụng AI mã nguồn mở (tiếp theo)

#### Quy trình kiểm tra và xác thực mã nguồn mở

Việc triển khai **mô hình AI mã nguồn mở** không chỉ là việc tải về và sử dụng, mà còn cần một quy trình kiểm tra bảo mật rõ ràng và kỹ lưỡng. Điều này bao gồm việc **kiểm tra mã nguồn** của mô hình trước khi triển khai vào môi trường sản xuất, để đảm bảo rằng không có mã độc hay các lỗ hổng bảo mật tiềm ẩn.

Quy trình này bắt đầu từ việc lựa chọn các mô hình từ các kho mã nguồn uy tín như **GitHub** hay **Hugging Face**, nơi mà mã nguồn thường xuyên được cập nhật và kiểm tra. Tuy nhiên, điều này không có nghĩa là bạn có thể hoàn toàn yên tâm. Các công cụ như **OWASP AI Security** hoặc **Snyk** cung cấp các tính năng kiểm tra tự động cho mã nguồn và phụ thuộc (dependencies), giúp xác định sớm các vấn đề bảo mật.

Ví dụ, một công ty khởi nghiệp AI tại Mỹ đã sử dụng công cụ **Snyk** để quét mã nguồn và phát hiện một lỗ hổng bảo mật trong thư viện mã nguồn mở mà họ sử dụng. Việc phát hiện kịp thời giúp họ sửa chữa vấn đề trước khi triển khai lên môi trường thực tế, tránh được những thiệt hại lớn.

#### Quản lý quyền truy cập và khóa API

**Quản lý quyền truy cập** và **khóa API** trong môi trường AI mã nguồn mở là yếu tố then chốt để ngăn ngừa các cuộc tấn công từ xa. Với việc sử dụng **API** trong các mô hình AI, việc lạm dụng hoặc rò rỉ thông tin có thể dẫn đến các cuộc tấn công nghiêm trọng, như **tấn công SQL injection**, **Cross-Site Scripting (XSS)**, hoặc **Remote Code Execution (RCE)**.

Khi triển khai mô hình AI, một trong những bước quan trọng là đảm bảo rằng các khóa API không bị rò rỉ. Để làm được điều này, bạn cần thiết lập các chính sách và quy trình quản lý khóa API cẩn thận, như sử dụng **Vault** của HashiCorp hoặc **AWS Secrets Manager** để bảo vệ các thông tin nhạy cảm.

Ngoài ra, việc **phân quyền truy cập** hợp lý cũng là một phần không thể thiếu. Chỉ những người có quyền hạn mới có thể truy cập vào mô hình AI và các tài nguyên liên quan. Quá trình này có thể được thực hiện thông qua **Single Sign-On (SSO)** và **Multi-Factor Authentication (MFA)**, giúp tăng cường bảo mật và hạn chế việc lạm dụng quyền truy cập.

#### Các công cụ hỗ trợ bảo mật cho mô hình AI mã nguồn mở

Việc sử dụng công cụ bảo mật phù hợp là một cách hiệu quả để giảm thiểu các rủi ro bảo mật khi triển khai **mô hình AI mã nguồn mở**. Một số công cụ hiện nay cung cấp các tính năng quét bảo mật tự động, phát hiện lỗ hổng và đề xuất các biện pháp khắc phục, giúp tăng cường bảo mật cho mô hình AI.

1. **OWASP AI Security**: Cung cấp các quy trình bảo mật và kiểm tra mô hình AI. Đây là công cụ quan trọng giúp bạn kiểm tra và quét các mô hình AI mã nguồn mở trước khi đưa vào sử dụng.

2. **Snyk**: Dùng để quét mã nguồn và các thư viện phụ thuộc (dependencies) để phát hiện các lỗ hổng bảo mật, giúp bạn bảo vệ mô hình AI khỏi các mối đe dọa.

3. **Hugging Face Model Hub**: Nền tảng chia sẻ mô hình AI mã nguồn mở này không chỉ cung cấp mô hình mà còn có các công cụ bảo mật hỗ trợ kiểm tra mô hình trước khi sử dụng.

Sử dụng những công cụ này sẽ giúp bạn bảo vệ mô hình AI mã nguồn mở khỏi các rủi ro bảo mật, đồng thời đảm bảo rằng các mô hình bạn sử dụng có độ an toàn cao và không chứa mã độc.

FAQ: Các câu hỏi thường gặp về bảo mật mô hình AI mã nguồn mở

1. Làm thế nào để phát hiện mã độc trong mô hình AI mã nguồn mở?

Để phát hiện mã độc, bạn cần sử dụng các công cụ kiểm tra bảo mật tự động như **Snyk** hoặc **OWASP AI Security**. Những công cụ này sẽ quét mã nguồn và thư viện phụ thuộc, phát hiện bất kỳ mã độc hoặc lỗ hổng nào có thể gây nguy hại.

2. Quản lý khóa API trong môi trường AI mã nguồn mở như thế nào?

Quản lý khóa API cần sử dụng các công cụ như **HashiCorp Vault** hoặc **AWS Secrets Manager** để lưu trữ và bảo vệ các thông tin nhạy cảm. Đồng thời, áp dụng các biện pháp như **Multi-Factor Authentication (MFA)** và **Single Sign-On (SSO)** để hạn chế quyền truy cập trái phép.

3. Những mô hình AI mã nguồn mở nào an toàn để sử dụng?

Không có mô hình AI mã nguồn mở nào là hoàn toàn an toàn nếu không được kiểm tra kỹ lưỡng. Tuy nhiên, các mô hình được lưu trữ trên các nền tảng uy tín như **Hugging Face** và **GitHub** sẽ có nhiều người dùng và nhà phát triển kiểm tra, giúp giảm thiểu rủi ro. Tuy nhiên, luôn cần thực hiện kiểm tra bảo mật trước khi sử dụng.

4. Làm sao để bảo vệ dữ liệu khi sử dụng mô hình AI mã nguồn mở?

Bảo vệ dữ liệu khi sử dụng mô hình AI mã nguồn mở đòi hỏi phải có các chính sách bảo mật mạnh mẽ, bao gồm mã hóa dữ liệu, phân quyền truy cập hợp lý và sử dụng các công cụ như **MFA** để tăng cường bảo mật. Ngoài ra, bạn cần phải kiểm tra và xác thực mô hình AI trước khi đưa vào sử dụng để đảm bảo không có rủi ro về bảo mật.

Kết luận

Mặc dù mô hình **AI mã nguồn mở** mang lại nhiều lợi ích về mặt sự linh hoạt và khả năng tùy chỉnh, nhưng chúng cũng đi kèm với những rủi ro bảo mật nghiêm trọng. Tuy nhiên, những rủi ro này có thể được giảm thiểu nếu bạn áp dụng các quy trình kiểm tra bảo mật nghiêm ngặt, sử dụng các công cụ bảo mật phù hợp và quản lý quyền truy cập một cách cẩn thận.

Như vậy, việc triển khai mô hình AI mã nguồn mở không chỉ là một sự lựa chọn về công nghệ mà còn là một quyết định bảo mật chiến lược. Nếu bạn đang tìm cách bảo vệ hệ thống của mình khỏi các mối đe dọa bảo mật, hãy bắt đầu từ việc xác thực và kiểm tra mô hình AI ngay từ đầu. Và đừng quên rằng bảo mật là một quá trình liên tục—hãy luôn theo dõi và cập nhật các giải pháp bảo mật của bạn để đối phó với những mối đe dọa mới.

Hãy khám phá thêm các giải pháp bảo mật hiệu quả cho mô hình AI mã nguồn mở tại [TRANBAO.DIGITAL](https://tranbao.digital).

E aí, galera! Descobri esse tal de 2Q e fiquei curioso. Alguém já se aventurou por lá? Tem jogos legais? Me deem um feedback antes de eu me jogar de cabeça! Clica aqui: 2q

Yo, g365win looks like another contender. Hope their odds are competitive, tired of getting ripped off! Worth a look? Let me know what you think! g365win

**mounja boost official**

MounjaBoost is a next-generation, plant-based supplement created to support metabolic activity, encourage natural fat utilization, and elevate daily energywithout extreme dieting or exhausting workout routines.

**prodentim**

ProDentim is a distinctive oral-care formula that pairs targeted probiotics with plant-based ingredients to encourage strong teeth, comfortable gums, and reliably fresh breath

**men balance**

MEN Balance Pro is a high-quality dietary supplement developed with research-informed support to help men maintain healthy prostate function.

**backbiome**

Mitolyn is a carefully developed, plant-based formula created to help support metabolic efficiency and encourage healthy, lasting weight management.